Un diluvio de datos de física de alta energía se dirige hacia los servidores de CERN en Ginebra. La Organización Europea para la Investigación Nuclear (CERN) planea reiniciar el Gran Colisionador de Hadrones pronto a 3.5 TeV por haz, durante un par de años. Para eso es necesario, entre otras cosas, que los sistemas computacionales se amolden a la cantidad de datos que recibirán para analizarlos.

En vez de añadir un conjunto de nuevas computadoras, CERN está probando un entorno de virtualización del servidor que esperan tener listo para fin de año. Esto involucra usar software para segmentar la capacidad de proceso y almacenamiento del servidor y es una técnica que se ha vuelto popular en los últimos años.

Se planea dividir sus 4.000 servidores (que poseen unos 32.500 procesadores) en 35.000 servidores virtuales y manejar el flujo de datos desde Platform Computing Corp., en Markham, Ontario. Durante los próximos dos o tres años se podrían seguir segmentando servidores hasta 80.000 virtuales.

"Estamos limitados en la cantidad de energía y enfriamiento disponible", indicó Tony Cass, líder del grupo de operaciones e infraestructura de CERN. "Queremos exprimir hasta la última gota de los recursos que tenemos para hacer física".

El LHC tiene varios detectores de partículas, incluyendo ATLAS y CMS, que capturan datos de las colisiones. Para producir resultados, los científicos de CERN primero deben convertir los unos y ceros producidos por los detectores en imágenes significativas que muestren las huellas de las diferentes partículas producidas en las colisiones, explicó Cass. Luego necesitan analizar esas imágenes para entender lo que significan.

La captura y análisis de datos requiere un enorme poder computacional, pero no siempre en cantidades iguales. A veces se necesita más procesamiento para crear imágenes y otras para el análisis. Para relocalizar los recursos de los procesadores, Cass y su equipo deben determinar cuántos servidores serán requeridos para realizar alguna tarea. Si encuentran que más recursos son necesarios en otra parte, deben detener el procesamiento que se esté realizando en los servidores, reconfigurarlos y comenzar otra vez. Los servidores virtuales, sin embargo, pueden realizar esa tarea en forma dinámica usando el software de Platform Computing, sin la necesidad de interrumpir el trabajo que esté en progreso.

Cuando el LHC se vuelva a poner en línea en unas pocas semanas, se espera que lo haga en forma continua hasta finales de 2011. Las computadoras dedicadas al LHC, que corren unos 120.000 trabajos diarios, necesitarán trabajar a máxima eficiencia para asegurar que el flujo de datos de los detectores puedan ser rápidamente convertido en resultados.

"La presión en el equipo de computación se incrementará una vez que los datos reales estén aquí y los físicos compitan para producir artículos para las revistas y conferencias, especialmente si hay alguna señal de un descubrimiento", comentó Cass.

Según señaló Cass a Computing los investigadores expresaron preocupación de que los sistemas de virtualización signifiquen una caída del desempeño. Sin embargo él piensa que el acceso a CPU y la red no resulta un problema como sí parece un mayor desafío el acceso a los discos porque hay un ingreso y egreso de datos constante.

Por el momento, indicó Cass, están trabajando en un modelo de virtualización para un entorno de prueba con 20 máquinas, pero planean extenderlo el próximo año. Para eso deben convencer a los investigadores que sus trabajos se realizarán igual que en el pasado. "Tenemos 5.000 sistemas físicos, cada uno con 16 núcleos, lo que potencialmente soportan 80.000 máquinas virtuales", señaló.

Platform LSF y LHC

Para manejar los requerimientos de manejo de datos CERN desarrolló su propio sistema de manejo jerárquico de almacenamiento llamado CASTOR. Los robots de cintas de StorageTeck proveen la plataforma para el sistema.

Cuando un físico envía un trabajo que requiere acceso a los datos, el software que corre en cada servidor Linux de CASTOR encuentra y envía la data, que puede ser distribuida a través de cientos de unidades de almacenamiento. El problema parece surgir cuando muchos usuarios requieren acceso a diferentes conjuntos de datos.

"Platform LSF nos ayuda a sobrepasar nuestro desafío de manejo de almacenamiento al programar los requerimientos de usuarios", explicó Cass. Se eligen los servidores de archivos basados en una variedad de factores de utilización como uso de CPU, carga de entrada/salida, espacio en disco disponible, etc.

En eweek, Cass comentó que además de usar la solución Platform ISF están probando las soluciones cloud que convierte los clusters y grids en dinámicos entornos nube para HPC (Computación de Alto desempeño).

"Necesitamos una infraestructura que soporte nuestra existente grid en un entorno heterogéneo que pueda manejar tanto máquinas virtuales como físicas necesarias para nuestros proyectos".

Clusters, Grid y cloud: ¿En qué quedamos?

Una grid es una colección de computadoras, usualmente de varias instituciones en diferentes lugares, conectadas juntas para que los usuarios puedan compartir el acceso a su poder combinado. Son como los clusters o conjuntos de computadoras interconectadas, pero una grid es heterogénea: se pueden correr diferentes sistemas operativos y distinto hardware. Además los clusters suelen estar en una misma localización, mientras una grid se extiende sobre una LAN o WAN.

Por otro lado, un cluster se comporta como todo un sistema con un manejo central, mientras en una grid cada nodo es autónomo, una entidad independiente. Es decir, que por un lado tenemos un sistema distribuido pero centralizado (cluster) y por otro un sistema descentralizado (grid).

La nube (o computación cloud) es un concepto relativamente nuevo y en desarrollo. Implica que algunas compañías IT arrendan sus recursos de software e infraestructura como un servicio, a través de internet, cobrando por su uso. Amazon y Google son dos pioneras en el desarrollo de este nuevo paradigma.

La computación Grid del LHC

La computación grid le brinda al LHC no sólo un ahorro de coste. Para analizar los datos necesitarían un sistema muy poderoso, fuera de su alcance, si no fuera por la utilización de las facilidades que poseen las universidades y laboratorios.

Pero además, permite tener múltiples copias de los datos en diferentes lugares, óptimo uso de la capacidad de espacio, no hay un único punto de falla, el costo de mantenimiento y actualización es distribuido, se reduce el "sangrado científico" que se produciría si los investigadores fueran forzados a dejar sus países para acceder a los recursos, ofrecer nuevas tecnologías, reconfigurar el sistema con relativa facilidad, entre otras ventajas.

¿Se puede usar la nube para la ciencia?

Hay múltiples ejemplos del uso de las grid en ciencia. ¿Puede pasar lo mismo con las nubes? La virtualización parece ser clave en esto porque permite mayor control para el usuario.

Un interesante artículo en IEEE Internet Computing (1) aborda el tema y destaca que un obstáculo actual es la no compatibilidad de imágenes para crear máquinas virtuales, ya que las implementaciones (VMware, Xen, etc) usan distintos formatos de disco, así como otras cuestiones de compatibilidad del entorno.

Un proyecto que vincula a la nube con la ciencia es Science Clouds, un proyecto beta en el cual algunos investigadores están realizando pruebas interesados en usar la computación cloud para proyectos científicos. Un ejemplo reciente fue el uso de la nube para el experimento STAR. La iniciativa estudia las propiedades fundamentales de la materia en el plasma Quark-Gluón. Los recursos del proyecto corren en Open Science Grid. Sin embargo, dos semanas antes de una conferencia realizaron una simulación usando Nimbus, una implementación de código abierto de Amazon EC2 que permitió a los científicos acceder a clusters virtuales a través de imágenes desplegadas en máquinas virtuales. (2)

Ahora, la virtualización de los servidores del CERN, usando los servicios del software de Platform, apuntan a combinar la infraestructura grid existente con el poder de la nube.

Virtualización

En informática, virtualización se refiere a la abstracción de los recursos de una computadora, llamada Hypervisor o VMM (Virtual Machine Monitor) que crea una capa de la abstracción entre el hardware de la maquina física (host) y el sistema operativo de la maquina virtual (virtual machine, guest), siendo un medio para crear una versión virtual de un dispositivo o recurso, como un servidor, un dispositivo de almacenamiento, una red o incluso un sistema operativo, donde se divide el recurso en uno o más entornos de ejecución.

Esta capa de software (VMM) maneja, gestiona y arbitra los cuatro recursos principales de una computadora (CPU, Memoria, Red, Almacenamiento) y así podrá repartir dinámicamente dichos recursos entre todas las maquinas virtuales definidas en el computador central. De modo que nos permite tener varios ordenadores virtuales ejecutándose sobre el mismo ordenador físico.

Fuentes y links relacionados

- Computing.co.uk: Q&A: CERN group leader of fabric infrastructure and operations, Tony Cass

- Scientificamerican.com: CERN Gears Up Its Computers for More Atom Smashing , por Larry Greenemeier

- Comparison of Grid Computing vs. Cluster Computing

- Grids and clouds: What's in a name?

- World-Renowned Nuclear Physics Laboratory Explores Cloud Computing with Platform ISF and Platform ISF Adaptive Cluster

- La computación GRID para el LHC está preparada

- The LHC Computing Grid in the starting blocks

- CERN Embraces Huge Cloud For Scientific Community

- Platform ISF Adaptive Cluster

- Platform LSF

- (1) Katarzyna Keahey, Mauricio Tsugawa, Andrea Matsunaga, Jose Fortes, "Sky Computing," IEEE Internet Computing, vol. 13, no. 5, pp. 43-51, Sep./Oct. 2009, doi:10.1109/MIC.2009.94

- (2) ISGTW: Clouds make way for STAR to shine

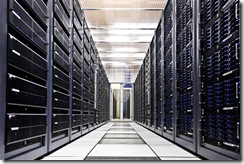

Sobre las imágenes

- Imágenes del centro de computación durante la instalación. PC Farm. Globo Grid. Crédito: CERN

Etiquetas:

Física en Blogalaxia-Ciencia en Bitácoras.com

No hay comentarios.:

Publicar un comentario