Desde el descubrimiento del primer exoplaneta, alrededor de la estrella 51 Pegasi, más de 400 planetas alrededor de otras estrellas se han descubierto. Pero estos objetos, a diferencia de otros, no tienen nombre, sino una designación científica.

Un astrónomo propone darles un nombre a los exoplanetas.

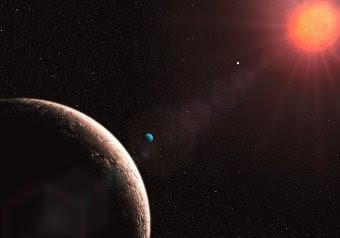

Gliese 581, el planeta más liviano

Gliese 581, el planeta más liviano

Wladimir Lyra es Brasilero. Estudió en la Universidad Federal de Río de Janeiro. En 2002 fue elegido para un trabajo de verano de 10 semanas para el Instituto de Ciencia Espacial Hubble en Baltimore. Estuvo en Chile con el proyecto CTIO. En 2004 comenzó su doctorado en la Universidad de Uppsala, Suecia. Luego de 4 turbulentos años, 11 papers e incontables noches codificando y haciendo simulaciones sobre discos protoplanetarios lo empezaron a llamar "Doctor". Ahora es un postdoctorando en el Instituto Max Planck en Heidelberg. Además de tener el pasaporte repleto de sellos, habla fluído su portugués natal, español, francés y sueco.

En un reciente ensayo, un paper no enviado a ninguna publicación, sugiere nombres "apropiados" para los 403 exoplanetas conocidos a la fecha.

Nomenclatura científica vs. nombres "humanos"

Ciertamente, denominar a un exoplaneta como MOA-2008-BLG-310-L b no parece muy acertado, pero es el mote que recibió hasta ahora un reciente planeta de masa inferior a la de Saturno detectado en el Bulbo Galáctico.

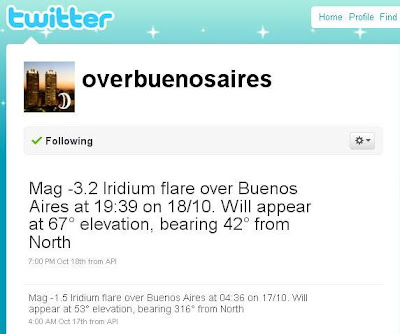

La UAI sostiene que no es práctico darles un nombre. Se argumenta que los descubrimientos se incrementarán exponencialmente y no sería posible nombrarlos a todos. Claro que también se descubren estrellas y sí es viable, al menos hasta ahora, ponerles una denominación más amigable. Incluso los asteroides tienen sus nombres. Hasta algunas galaxias, al menos las más cercanas, lo tienen. La UAI está analizando la creación de un sistema, que será menos romántico que lo que propone Lyra, pero más ordenado.

En la actualidad se utiliza el nombre de la estrella a la que pertenece el exoplaneta (según catálogo) seguido de una letra (comenzado por la b), si es que hay varios planetas en el sistema.

Nombrando a las estrellas Las estrellas más brillantes suelen tener nombre propio que les viene de antiguo. La gran mayoría vienen del griego (como Cástor) o del árabe (como Aldebarán), pero hasta las de magnitud 6 pueden nombrarse sistemáticamente de dos maneras:

El método de Bayer consiste en ponerle una letra, griega o latina, antes del nombre de su constelación en genitivo; por ejemplo: a Virginis.

El método de Flamsteed consiste en ponerle un número antes del nombre de su constelación en genitivo; por ejemplo: 67 Virginis.

Más información en

Nombre de las estrellas, de Antonio Herrera.

Pero no sólo se usan constelaciones. Los astrónomos asignan nombres a las estrellas según los catálogos a los que pertenecen. A lo largo de la historia se han realizado muchos catálogos: Johannes Bayer en

Uranometria hizo un atlas del cielo usando letras griegas. También existen otros: Flamsteed (1712), Lacaille (1742), Bradley (1760), Piazzi (1800) y Lalande (1801). Este último dio el número, magnitud y posición de 47 390 estrellas.

En la actualidad se usa mucho el catálogo de Henry Draper para nombrar a los exoplanetas. Por ejemplo el sistema HD 155358 tiene al menos dos planetas, b y c.

WASP-17b, el exoplaneta que va para atrás

WASP-17b, el exoplaneta que va para atrás

¿Por qué nombrar a los exoplanetas? Lyra argumenta que el Principio Copernicano es una razón principal. Nuestro lugar en el cosmos no es especial, por lo que no hay razón para que sólo los planetas en nuestro sistema solar tengan nombre. Una extrapolación de esta idea se conoce como Principio de mediocridad.

Algunos planetas poseen un nombre sugerido. Por ejemplo, al autor se le ocurrió que a 51 Pegasi b le sentaría bien el mote de "Belorofonte". Así se cruzó en la web con el sitio "Extrasolar planet naming society" en el que se sugiere justamente ese nombre.

Otra página, de Devon Moore, posee sugerencias para nombrar a más de 40 planetas, algunos que le parecen apropiados, otros que rechazaría.

Los tres planetas descubiertos alrededor de Upsilon Andromedae han sido apodados "Fourpiter", "Twopiter" y "Dinky" por niños de cuarto grado. Claramente los dos primeros poseen referencias a su tamaño en relación a Júpiter. Sin ofensa a los creativos niños, dice Lyra, no son ya los tiempos en los que Venitia Burney, la niña de 11 años, sugirió el nombre Plutón (el dios romano del submundo, no el perro de Disney!) para el alejado y frío ex-planeta, en 1930. A propósito, "Naming Pluto" ("Nombrando a Plutón") es un documental al respecto que cuenta la historia.

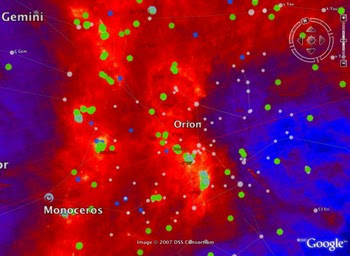

¿Cómo hacerlo entonces? Lyra sugiere retornar a la clásica tradición de utilizar la mitología Greco-Romana. El artículo contiene un tabla con los exoplanetas encontrados hasta ahora y las sugerencias de Lyra. ¿Método? La Enciclopedia de Exoplanetas de Jean Schneider (que contiene los 32 exoplanetas recientemente descubiertos), un diccionario de Mitología y algunas fuentes online. Para buscar un nombre apropiado, un manera que le parece razonable es la asociación con la constelación en la que se encuentra. Por ejemplo, el sistema Gliese 581, en Libra, podría ser llamado Themis, la diosa de la justicia.

¿Y las constelaciones del Sur? Las constelaciones clásicas descritas en el Almagesto eran, por supuesto, dibujadas sobre las estrellas visibles desde el hemisferio norte únicamente. Y usaron los mitos para buscar nombres apropiados. Pero las constelaciones australes definidas durante la Era de la Navegación no están asociadas a figuras mitológicas.

Para eso, Lyra reconoce a Moore el mérito de saber qué hacer. Sencillamente asociarlas con la mitología clásica: Horologium (el reloj de arena) podría ser Cronos, el dios del Tiempo. De la misma forma se pueden asociar los nombres en Uranometría, de Bayer, con la mitología clásica.

A continuación, el autor menciona los mitos de navegación -La Ilíada, la Odisea, la Eneida- como fuentes de referencias clásicas. Y también propone, de la literatura portuguesa, "Las Lusíadas", epopeya del Renacimiento de Luís de Camões, de 1572. El título significa "los hijos de Luso". Según la leyenda, los portugueses descienden de Luso, hijo del dios Baco, que conquistó por las armas un territorio que después será Lusitania, o sea, Portugal.

Esta sugerencia abre la puerta a la inclusión de otros mitos y asociaciones literarias: La canción de Rolando, Los Nibelungos, La Divina Comedia, Don Quijote, etc. Y también cita "The Columbiad" ("La Colombiada"), de Joel Barlow (1807).

En las siguientes páginas, Lyra propone asociaciones mitológicas clásicas con las constelaciones para, finalmente sugerir nombres para los 403 exoplanetas descubiertos a octubre 2009.

Las críticas

No digo que la propuesta esté mal ni bien, sólo me hago preguntas:

Existiendo tantos objetos distintos (estrellas, planetas, asteroides) el nombramiento podría ser engorroso y la lista a elegir, finita. Quizás lo mejor sea sí nombrar amigablemente a las estrellas y, a partir de ellas, a los planetas y asteroides. En nuestro sistema solar, estos objetos, con sus nombres actuales, serían "especiales" porque los encontramos antes. Tener un sistema arbitrado por la UAI generaría menos complicaciones y rodeos.

La idea de nombrar a los exoplanetas más amigablemente, no deja de tener un atractivo: atraería al público general. Pero, en el caso de las estrellas que hospedan planetas y que se encuentran en una constelación del Hemisferio Sur, ¿no sería mucho más apropiado utilizar la mitología de las civilizaciones precolombinas, por ejemplo? Mayas, Incas, Aztecas, -habría que agregar las que habitaron en Australia, Sudáfrica, etc- poseían sus deidades y estudiaron los movimientos celestes con gran precisión. El "Nuevo Mundo" también merece un "Nuevo Cielo", no creen? Y para ser verdaderamente nuevo, deberíamos incluir otras mitologías como la Japonesa, Africana y China.

Sin embargo, tal como apunta el autor, esto también genera problemas ya que una palabra puede resultar ofensiva en un idioma y no en otros. El ejemplo que da es "Uranus" para los angloparlantes.

Pero esto nos devuelve al comienzo, al también llamado "Principio de Mediocridad", la idea de que no somos especiales. El universo sería un abanico representativo de la humanidad (mucho mejor que hasta ahora, más inclusivo). Pero, al mismo tiempo, eso estaría indicando que sí creemos ser especiales.

Claro, dirá usted, no hay otra forma. Ya sea que usemos nombres latinos/griegos, aztecas, africanos, anglosajones o asiáticos; o incluso números (que actualmente surgen de catálogos creados por personas, como el mencionado catálogo HD), estamos haciendo referencia a nuestra cultura "terráquea". Es inevitable.

¿Y si usamos un generador de números aleatorios, mucho menos romántico y literario, mucho menos "humano", menos antrópico? Estaríamos ante un universo de "exoplanetas mediocres". Como nosotros.

Fuentes y links relacionados

Sobre las imágenes

- WASP-17b. Ilustración: ESA/C. Carreau

- Gliese 581. Crédito: ESO.

- Las constelaciones clásicas basadas en "Los Fenómenos" de Arato según Johann Buhle (siglo XVIII)

Etiquetas:

Astronomía en Blogalaxia-Ciencia en Bitácoras.com

La misión Kepler no sería capaz de detectar exoplanetas hasta, al menos, 2011, por un problema con sus amplificadores.

La misión Kepler no sería capaz de detectar exoplanetas hasta, al menos, 2011, por un problema con sus amplificadores.

WASP-17b,

WASP-17b,

Imagen del cúmulo JKCS041. Crédito: CFHT, Terapix, WIRDS

Imagen del cúmulo JKCS041. Crédito: CFHT, Terapix, WIRDS

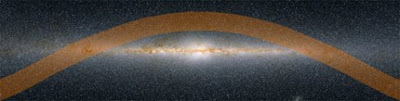

Imagen que muestra la distribución del Cinturón de Gould en el cielo. El área marcada en naranja ilustra el Cinturón mostrado contra el disco de la Vía Láctea, que contiene al Sistema Solar.

Imagen que muestra la distribución del Cinturón de Gould en el cielo. El área marcada en naranja ilustra el Cinturón mostrado contra el disco de la Vía Láctea, que contiene al Sistema Solar.